하루 만에 또 새로운 ‘세계 최고 오픈 소스 모델’이 등장했다. 하지만, 자칭 ‘세계 최고 오픈 소스 모델’인 하이퍼라이트의 '리플렉션 70B'와는 달리, 중국 인공지능(AI) 스타트업 딥시크가 선보인 모델은 전문가들의 평가도 대단하다.

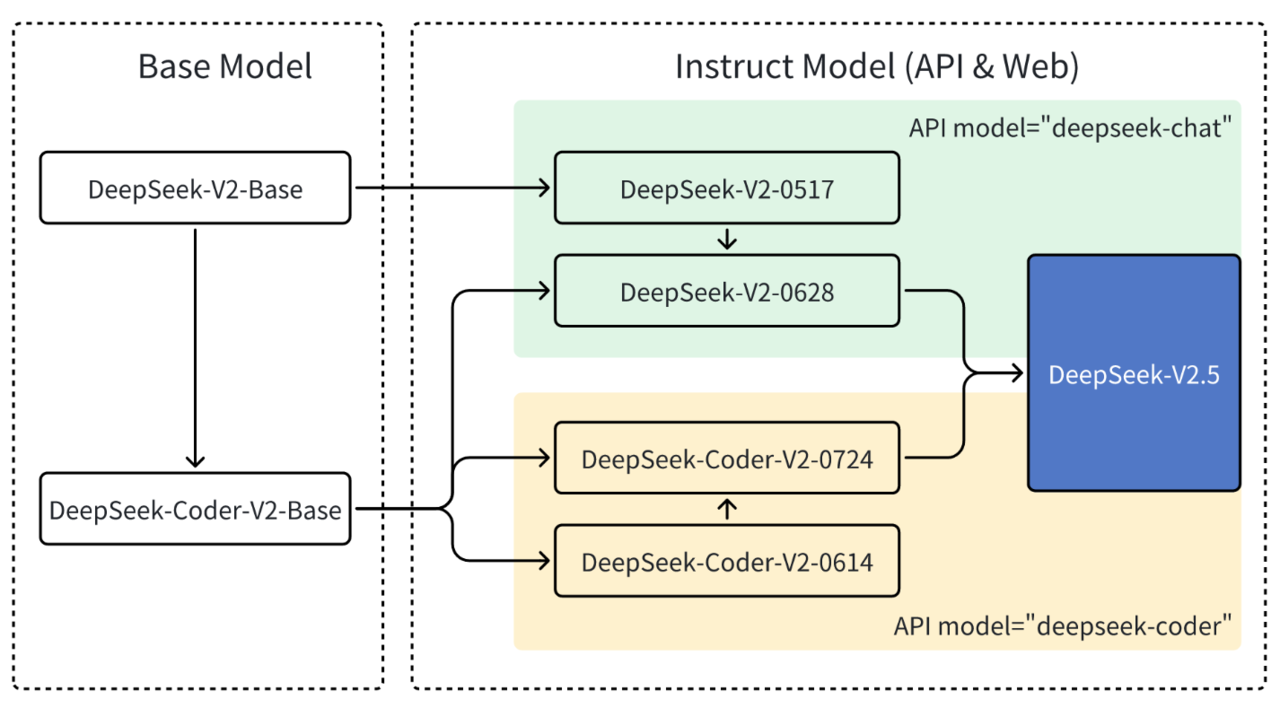

벤처비트는 10일(현지시간) 딥시크가 이전 모델인 '딥시크-V2-0628'의 일반 언어 처리 기능과 '딥시크-코더-V2-0724'의 코딩 기능을 통합한 '딥시크-V2.5(DeepSeek-V2.5)’를 오픈 소스로 출시했다고 보도했다. 이 모델은 지난 5일 리플렉션 70B 출시 하루 뒤인 6일 공개됐다.

딥시크-V2.5는 글쓰기 능력과 지시사항 준수, 인간 선호도 정렬 기능이 강화됐다. 현재 허깅페이스에서 상업적 용도로 무료 사용 가능하며, 웹과 API를 통해도 사용할 수 있다.

특히 함수 호출을 통해 외부 도구를 호출할 수 있고, JSON 출력 모드를 사용해 유효한 JSON 객체를 생성할 수 있다. 또 접두어와 접미어를 제공하면, 모델이 그 사이 콘텐츠를 완성하는 'FIM(Fill In the Middle)' 기능을 제공한다.

BF16 포맷으로, 80GB GPU 8개를 사용하면 딥시크-V2.5를 로컬에서 실행할 수 있다.

딥시크-V2.5 아키텍처 (사진=딥시크)

아키텍처에는 캐시를 줄여 추론 속도를 개선하는 '다중 헤드 잠재 주의(MLA)' 압축 기술이 포함, 모델의 성능 손실없이 컴퓨팅 리소스를 효율적으로 사용할 수 있다.

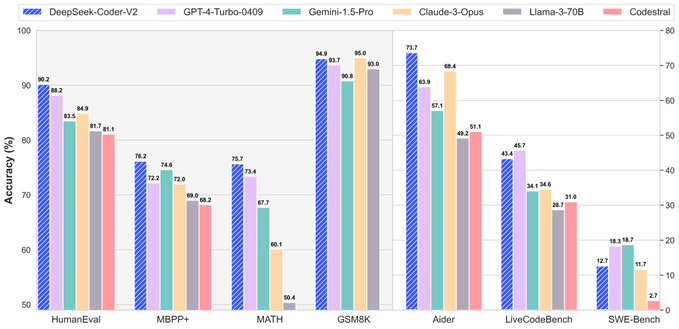

성능 면에서도 주요 벤치마크에서 뛰어난 성적을 거뒀으며, 특히 자연어 처리와 코딩 작업에서 우수성을 입증했다.

벤치마크 결과, 딥시크-V2.5는 알파카이밸 2.0 벤치마크에서 정확도 50.5를 보이며, 딥시크-V2-0628의 46.6 및 딥시크-코더-V2-0724의 44.5보다 개선됐다.

아레나하드 벤치마크에서는 76.2로, 딥시크-V2-0628의 68.3 및 딥시크-코더-V2-0724의 66.3보다 높은 정확도를 기록했다.

휴먼이밸 파이썬 벤치마크에서 딥시크-V2.5는89를 기록하며, 딥시크-V2-0628의84.5 및 딥시크-코더-V2-0724의 87.2보다 개선됐다.

중국어 내부 평가에서 오픈AI의 'GPT-4o 미니'와 'GPT-4o'보다 우수한 성과를 보인 것으로 나타났다.

마지야르 파나히 CNRS 수석 엔지니어는 X(트위터)를 통해 딥시크-V2.5가 "세계 최고의 오픈소스 LLM"이라며 “획기적인 성능을 보였음에도 불구하고 더 많은 주목을 받지 못한 것이 놀랍다”라고 말했다.

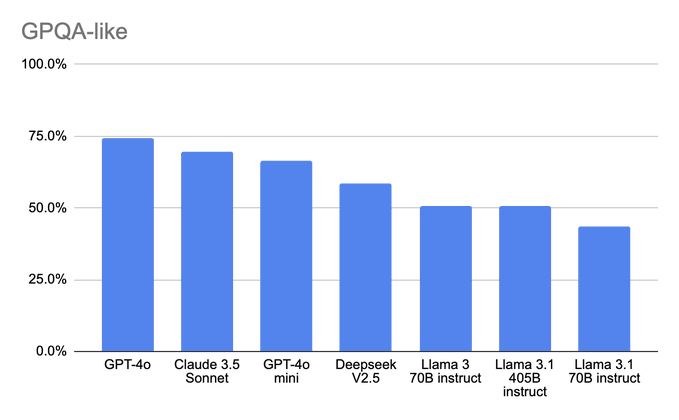

하이퍼라이트의 '리플렉션 70B' 벤치마크를 두고 사기를 저질렀다고 비판한 신 메가미 보손도 X에 대학원 수준의 GPQA 벤치마크 결과를 게시했다.

이에 따르면 딥시크-V2.5는 메타의 '라마 3-70B 인스트럭트'와 '라마 3.1-405B 인스트럭트'보다 성능이 우수했지만, GPT-4o 및 GPT-4o 미니, '클로드 3.5 소네트'와 비교하면 성능이 떨어지는 것으로 나타났다.

그는 "딥시크-V2.5는 라마 3.1-405B 모델을 포함해 내가 테스트한 오픈 소스 모델 중 실제로 가장 성능이 좋은 모델”이라고 말했다.

한편, 딥시크는 '큐원'으로 유명한 알리바바와 함께 중국에서 손꼽히는 오픈 소스 기업으로 알려져 있다.

특히 모회사인 중국 하이-플라이어는 엔비디아의 'A100' GPU를 1만개 이상 보유한 6개 중국 그룹 중 하나로 알려졌다.

출처 : AI타임스(https://www.aitimes.com/news/articleView.html?idxno=163301b)